В мире компьютеров и сетей все данные сохраняются и передаются в виде битов. Бит — это базовая единица измерения информации, которая может иметь два значения: 0 или 1. Используя комбинации битов, мы можем кодировать различные символы, числа и другие типы данных.

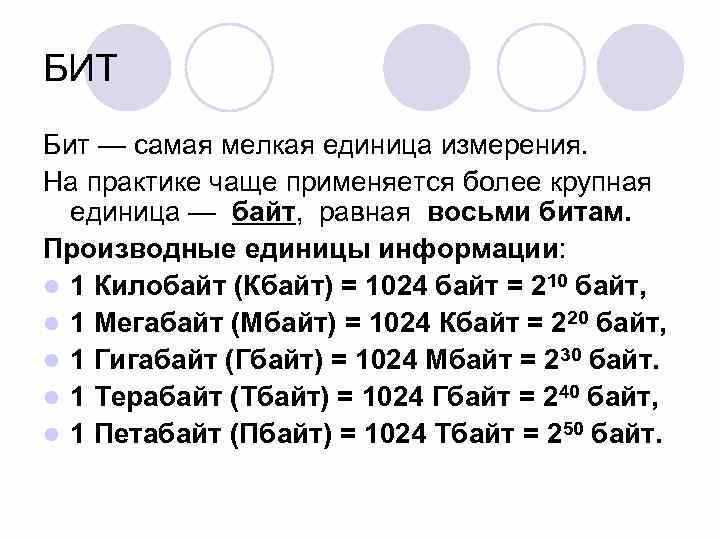

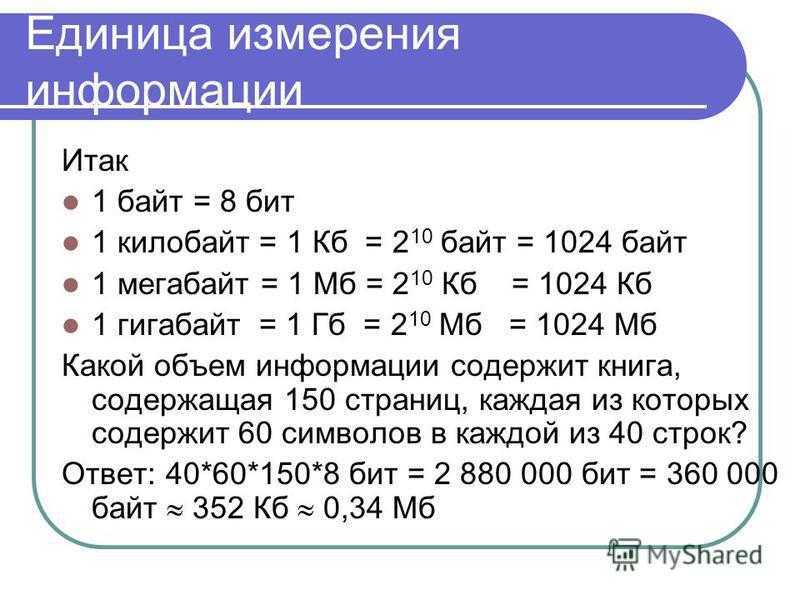

Байт — это группа из 8 битов. Когда мы говорим о размере памяти или объеме данных, мы обычно используем байты как единицу измерения. Например, если у нас есть файл размером 1 килобайт (1 КБ), это означает, что в нем содержится 1024 байта (1 КБ = 1024 Б).

Исторически сложилось, что размер байта составляет 8 битов. Почему именно 8? Во-первых, это количество позволяет кодировать достаточное количество символов и чисел. Если бы байт состоял из, скажем, 4 битов, то мы смогли бы закодировать только 16 различных символов или чисел. Это было бы недостаточно для большинства приложений.

Кроме того, 8-битные байты удобны для работы с компьютерными системами, так как они соответствуют размеру регистра в процессоре. Это означает, что процессоры могут эффективно выполнять операции с данными размером в 8 битов, не разделяя их на более малые части. В результате это ускоряет работу компьютера и упрощает процессы обработки информации.

Происхождение термина «байт»

Термин «байт» впервые был введен в 1956 году швейцарским инженером Вернером Бухгольцем при разработке компьютера IBM 704. Он использовал термин для обозначения единицы памяти, которая состояла из 8 бит.

Слово «байт» происходит от английского термина «byte», который был сокращением от «by eight» (по восемь). Такое название было выбрано, потому что первые компьютеры IBM использовали 8-битные блоки памяти для хранения информации.

С течением времени термин «байт» стал широко применяемым и использовался для обозначения единицы измерения объема информации. В настоящее время байт является наиболее распространенной единицей измерения информации в компьютерных системах.

Также стоит отметить, что размер байта может отличаться в различных системах. Например, в некоторых компьютерных системах размер байта может быть 16 или 32 бита. Однако наиболее распространенный размер байта составляет 8 бит.

Первое использование термина

Термин «байт» был введен в 1951 году в статье Фрэнка Розенблатта, опубликованной в журнале «Эконометрика». Изначально, термин «байт» использовался для обозначения восьми бит, то есть минимального адресуемого блока информации в компьютере.

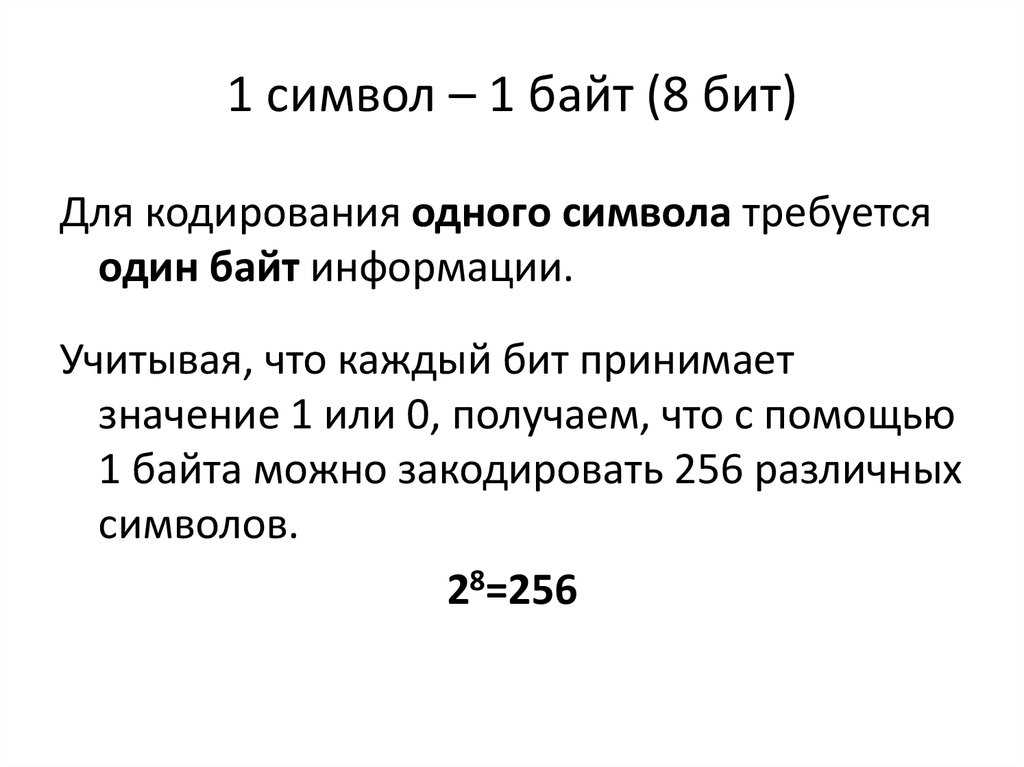

В то время компьютеры оперировали только с двоичной системой счисления, поэтому восьми бит были достаточны для представления всех возможных комбинаций. Таким образом, один байт мог хранить в себе 256 различных значений: от 0 до 255.

В дальнейшем, с развитием компьютерных технологий, стандартным размером байта стало 8 битов. Данный размер стал применяться всеми производителями компьютеров и считался универсальным.

С течением времени стандартные размеры байта не менялись, и его значение остается неизменным до сегодняшнего дня. Благодаря унификации размера байта, стало возможно разработка программ и оборудования, совместимого между различными производителями.

Стандартизация размера байта

Размер байта является ключевым понятием в компьютерной науке и информационных технологиях. Долгое время существовало несколько разных определений размера байта, но в конечном итоге было принято стандартное значение в 8 бит.

Бит — это минимальная единица информации, которая может принимать одно из двух значений: 0 или 1. Биты используются для представления данных в компьютерах и цифровых устройствах.

Однако, вплоть до середины 20 века, не было единого соглашения о размере байта. Исторически сложилось несколько разных значений. Например, в некоторых системах байт имел размер 4 бита, а в других — 6, 7 или 9 бит. Это приводило к совместимостным проблемам и необходимости разработки специфических технологий для работы с разными размерами байта.

Также не было единого стандарта для обозначения размера байта. Некоторые производители использовали термины «word» или «byte» для обозначения различных значений. Например, в одной системе «word» мог означать 4 бита, а в другой — 8 бит.

В конечном итоге, стандартизация размера байта произошла в 1960-х годах. Международная организация по стандартизации (ISO) приняла решение установить размер байта в 8 бит. Это решение было принято, так как 8 бит позволяют представлять 256 различных значений, что было достаточным для большинства компьютерных систем и устройств.

Стандартизация размера байта в 8 бит позволила решить проблемы совместимости и обеспечить единообразие в представлении данных. В настоящее время практически все компьютерные системы и устройства работают с байтами размером 8 бит.

Развитие байта в современных компьютерных системах

Байт – это основная единица измерения в информатике, используемая для представления цифровых данных в компьютерных системах. В истории развития информационных технологий байт прошел длительный путь, и его значение и размер изменились со временем.

Первоначально байт использовался для представления одного символа. В первых компьютерных системах, таких как ЭВМ или мейнфреймы, байт был равен 6 битам. Это позволяло представлять только небольшое количество символов, например, только заглавные буквы английского алфавита и несколько специальных символов.

Однако с развитием компьютерных технологий и расширением возможностей хранения и обработки данных, размер байта был увеличен до 8 битов. Это позволило представлять уже 256 различных символов, включая все буквы латинского алфавита, цифры, специальные символы и некоторые дополнительные символы.

В современных компьютерных системах байт остается основной единицей измерения данных. Однако по мере развития технологий и повышения производительности компьютеров возникают необходимость в работе с более крупными объемами данных. Для этого используются множественные байты, объединяемые в так называемые «слова» или «блоки».

Слово – это последовательность байтов фиксированной длины, которая может быть использована для представления различных типов данных в компьютерных системах. В зависимости от архитектуры и целей системы, размер слова может быть разным: 16 бит, 32 бита, 64 бита и т.д.

Существуют также понятия «полубайта» и «четвертьбайта», которые используются для работы с битами и полубайтами. Они позволяют эффективно использовать ресурсы компьютерной системы, особенно при обработке мультимедийных данных или встроенных системах с ограниченными возможностями.

Таким образом, байт продолжает оставаться основной единицей измерения данных в современных компьютерных системах. Размер и значение байта могут меняться в зависимости от архитектуры и целей системы, но его роль как базовой единицы остается неизменной.

Использование байта в памяти и процессорах

Байт является основным единицей измерения информации в компьютерных системах. Он используется для хранения данных в памяти и передачи информации между процессором и устройствами ввода-вывода.

Один байт представляет собой последовательность из 8 битов. Каждый бит может принимать два значения: 0 или 1. Сочетание 8 битов позволяет представить 256 различных комбинаций (2^8), что соответствует числам от 0 до 255.

В памяти компьютера байты используются для хранения данных. Числа, символы, тексты и другие типы информации представляются в виде последовательности байтов. Каждому символу или числу в таблице символов ASCII или Unicode соответствует определенный байтовый код.

В процессорах байты играют важную роль при выполнении операций над данными. Они используются в регистрах процессора для хранения промежуточных результатов вычислений, адресов в памяти и других операндов. Байты также используются для передачи данных между процессором и другими устройствами, такими как жесткие диски, видеокарты и сетевые адаптеры.

Использование байтов в процессорах и памяти имеет свои особенности. Некоторые архитектуры процессоров могут обрабатывать или передавать данные только по 8-битовым блокам, поэтому в таких системах байт является наименьшей адресуемой единицей памяти. Другие архитектуры могут использовать байты в качестве базовой единицы, но также поддерживать операции над большими блоками данных, такими как слова или двойные слова.

Байт остается одним из основных элементов компьютерных систем, несмотря на появление более крупных единиц измерения, таких как килобайт, мегабайт и гигабайт. Байтовая ориентация используется для определения размеров файлов, объемов памяти, пропускной способности каналов связи и других параметров, связанных с обработкой информации.

Байт как единица измерения информации

Байт является основной единицей измерения информации в компьютерных системах. Название «байт» происходит от английского слова «byte», которое в переводе означает «кусочек» или «укус». Байт представляет собой набор из 8 бит. Каждый бит может иметь два значения: 0 или 1.

Байт используется для хранения и передачи информации в компьютерных системах. Он может представлять различные типы данных, такие как символы, числа или цвета. Например, один символ алфавита (например, буква «А» или «а») может быть представлен одним байтом.

Количество байт, необходимых для хранения или передачи определенной информации, зависит от ее объема. Чем больше информации требуется представить, тем больше байт будет использовано. Например, для хранения целого числа обычно требуется 4 байта, а для хранения числа с плавающей запятой — 8 байт.

Байт также используется для измерения объема памяти или размера файлов на компьютере. Например, оперативная память компьютера может иметь объем, выраженный в гигабайтах или терабайтах. Размер файлов на жестком диске также измеряется в байтах.

В компьютерных системах данные обычно передаются и обрабатываются блоками байтов. Например, при скачивании файла из Интернета он передается блоками байтов. Блоки байтов также используются для передачи данных по сети или записи на физический носитель информации, такой как дискета или жесткий диск.

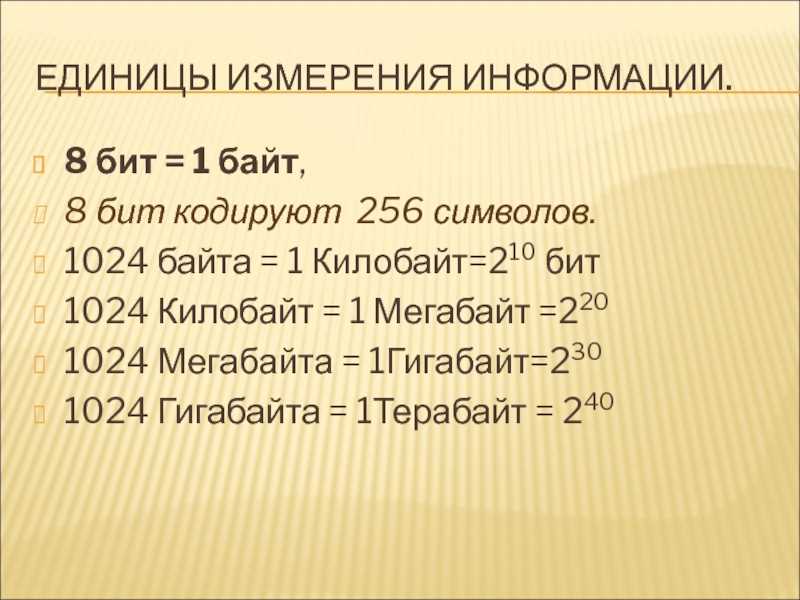

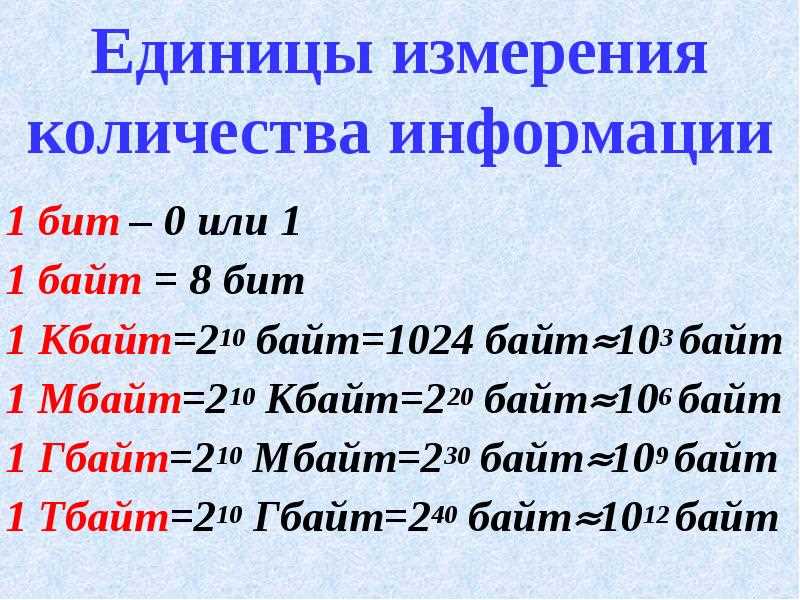

| Единицы измерения информации | Значение |

|---|---|

| Бит (bit) | 0 или 1 |

| Байт (byte) | 8 бит |

| Килобайт (KB) | 1024 байта |

| Мегабайт (MB) | 1024 килобайта |

| Гигабайт (GB) | 1024 мегабайта |

| Терабайт (TB) | 1024 гигабайта |

В заключение, байт является основной единицей измерения информации в компьютерных системах. Он используется для хранения, передачи и обработки данных. Понимание того, как работает байт и как он используется, поможет вам лучше понять компьютерные технологии и работать с ними более эффективно.

Почему байт равен 8 битам

Байт — это единица измерения в компьютерных системах, которая обычно состоит из 8 бит. Однако вопрос о том, почему байт равен именно 8 битам, не так прост, как может показаться на первый взгляд.

Исторически сложилось так, что байт был выбран как основная единица измерения в компьютерах и информационных системах. Вначале байт состоял из 6 бит, затем он был расширен до 8 бит для обеспечения большей гибкости и возможности представления большего количества символов и значений.

Основное обоснование выбора 8 бит в байте заключается в следующем:

-

Представление символов: Восьмибитный байт позволяет представлять большое количество символов из различных алфавитов. Например, ASCII-кодировка использует 7 бит для представления основного набора символов, а восьмой бит может быть использован для расширенных символов или специальных значений.

-

Удобство обработки данных: Восьмибитный байт обеспечивает более гибкую структуру данных. Например, он позволяет представлять числа от 0 до 255 (2^8-1), что является удобным для многих вычислительных операций и операций с памятью.

-

Совместимость и стандартизация: Восьмибитный байт стал стандартом в компьютерных системах и сетях. Он широко используется в различных протоколах передачи данных, файловых форматах и операционных системах. Это обеспечивает совместимость и переносимость данных между различными системами.

Таким образом, 8 бит в байте стали стандартом благодаря своей универсальности, гибкости и эффективности. Этот выбор был обусловлен потребностями представления символов, обработки данных и обеспечения совместимости между различными компьютерными системами и сетями.